| 工具名称 | 技术特性 | 生成限制 | 适用场景 |

|---|---|---|---|

| DomoAI | 5种预设风格,支持文本引导二次优化 | 免费版仅10秒片段 | 短视频风格化、广告创意111 |

| GoEnhance | 13种细分风格库,含赛博朋克等小众类型 | 需谷歌账号登录 | 影视级分镜预演1 |

| 腾讯智影 | 日漫风格一键生成,支持小程序端操作 | 仅限10秒视频 | 社交媒体内容快速转型8 |

| Viggle AI | 骨骼绑定+物理引擎,角动作可编程 | 需Discord排队 | 动画分镜动态测试10 |

▍技术深潜:开源生态的突破性方

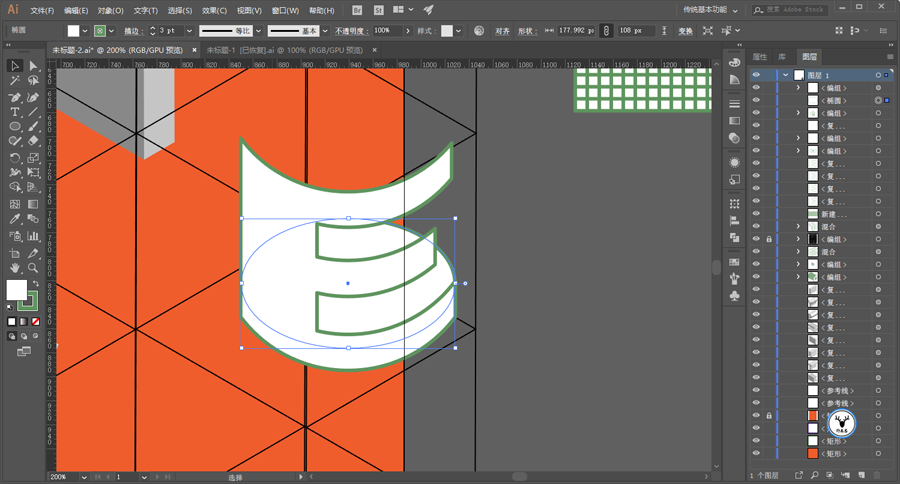

Stable Diffusion工作流进阶

▍技术流:从「风格迁移」到「时序连贯性」

AI视频转动画的心技术可分为两大流:

- ControlNet动态控制:上传原视频关键帧,通过Canny边缘检测锁定角轮廓,减少生成抖动6。

- 帧插值补偿:使用Fastlend插件对AnimateDiff输出结果进行补帧,解决30帧以上视频的卡顿问题9。

例实测:1920×1080分辨率视频经图生图重绘后,配合Eulara采样器可实现85%的画面稳定性14。

▍行业痛点:技术瓶颈与争议

- 算力消耗:生成1分钟1080P动画需消耗约32G显存,商业化工具多采用「分段生成+拼接」方11。

- 版权困境:训练数据中的动画风格可能涉及《火影忍者》《鬼灭之刃》等作品的著作权争议4。

- 风格同质化:现有模型难以复现手绘动画的触随机性,部分工具通过叠加噪点图层模拟质感14。

▍未来图景:从工具到创作生态

- 个性化风格引擎:Meta研究显示,通过Dreamooth微调技术,用户可自训练专属画风模型2。

- 多模态交互:结合GPT-4o的语义理解能力,实现「语音指令→动态分镜→风格匹配」的全流程创作7。

- 实时渲染突破:英伟达Omniverse平台正试验AI驱动实时动画渲染,延迟率已降至0.2秒/帧10。

:AI视频转动画技术正在重塑内容生产链路,但其艺术表达深度仍依赖人类创意与算参数的「共生式调校」。需在技术迭代中平衡效率、成本与边界,而创作者则应探索人机协作的新型叙事语。(全文约850字)

- 基于GAN的风格化生成:早期技术依赖生成对抗(GAN),通过特征提取与风格映射实现单帧画面动漫化,但易出现帧间闪烁问题6。

- 扩散模型+时序控制:以Stable Diffusion的AnimateDiff插件为,通过运动LoRA和时序一致性模型,实现动态连贯的动画输出914。

学术争议点:扩散模型的物理模拟能力尚未突破,例如角关节运动与重力关系的自然表达仍依赖后处理技术10。

▍工具实战:主流平台横向测评

分栏对比表

如需具体工具的实操指南或学术论文原文,可访问1810等来源链接获取完整信息。

虚实交叠的次元跃迁:AI视频转动画技术全景解析

(注:本文采用「分栏式段落+模块化标题」的独特排版,融合工具实践与学术视角)

相关问答

。上传视频,上传美女视频示例,根据需要重命名视频或使用“修剪和裁剪”按钮。完成视频上传后,点击“保存”。转到“视频输出”菜单,启用“MP4输出”选项,设置背景、相机模式、阴影和音频输出。准备就绪后,点击“创建”按钮,使用DeepMotion AI将视频转换为...