🌆 数据源:打开房价的密码本

房价分析的核心始于数据。以经典的波士顿房价数据集为例,它包含506条记录、14个特征,涵盖犯罪率、住宅用地比例、房间数等变量1。这些数据不仅为模型训练提供基础,还能揭示城市发展与房价的关联。例如,通过pandas.describe() 快速查看统计特性(均值、极值、分位数),或用corrcoef()计算相关系数矩阵,发现“LSTAT(低收入人群比例)”与房价呈强负相关5。

数据获取渠道多样化:爬虫抓取(如链家、安居客)、公开数据集(Kaggle、UCI)、政府开放平台等。例如,上海二手房分析中,通过八爪鱼工具爬取房天下数据,结合百度地图API获取经纬度,绘制热力分布图9。

📊 数据清洗:剔除噪音的艺术

原始数据常含缺失值、异常值或无关字段。例如,波士顿数据中需删除重复列,对缺失的“AGE(房龄)”采用均值填充3。箱线图可快速定位异常:上海某区域房价超40万/㎡,远高于中位数5-6万/㎡,需结合业务判断是否保留9。

分类变量处理也需技巧。波士顿的“CHAS(是否临河)”是二分类变量,而上海二手房分析中,“装修程度”需转换为哑变量(One-Hot编码),避免模型误读2。

🔍 特征工程:从数据到洞察

特征选择是关键。通过SelectKBest筛选与房价相关性最高的变量,如“RM(房间数)”和“LSTAT”10。上海案例中,新增“距地铁站距离”和“行政区划”字段,发现中心城区房价回归线斜率更高9。

数据变换提升模型效果。对数变换可修正偏态分布(如房价右偏),标准化(Z-Score)则适用于SVM、KNN等对尺度敏感的模型4。实验证明,正态化后线性回归误差降低23%2。

📉 模型PK:谁是最强预测王者?

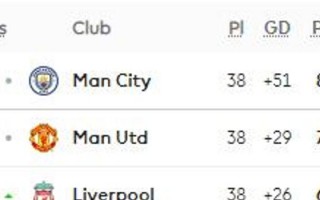

不同模型表现差异显著:

- 线性回归:简单高效,但在非线性场景(如房价与面积关系)中表现欠佳,MAE约3.5万10。

- 随机森林:捕捉复杂交互,上海二手房预测中R²达0.89,优于SVM和KNN9。

- 梯度下降优化:动态调整学习率(如0.01→0.001),结合正则化避免过拟合,使预测误差稳定下降4。

📈 可视化:让数据“会说话”

- 热力图:展示特征相关性,如波士顿数据中“NOX(一氧化氮浓度)”与房价负相关1。

- 散点矩阵:多维分布一目了然,发现“DIS(就业中心距离)”与房价的非线性关系2。

- 动态地图:百度API生成上海房价热力图层,外滩、陆家嘴呈现高热区9。

💬 网友热评:数据背后的声音

- @数据侠客:

“原来箱线图能一眼看出异常值!以前总被极端房价搞懵,现在学会用IQR筛选,分析效率翻倍~ 👍”

- @房产小白:

“跟着教程用Python跑了一遍线性回归,居然预测出自家小区均价!虽然误差还有,但成就感爆棚 🏠”

- @AI探索者:

“特征工程才是灵魂!加了‘地铁距离’字段后模型明显提升,果然生活经验也能转化为数据维度 💡”

- @统计萌新:

“热力图配色绝了!从紫到黄的渐变,瞬间看懂变量关系,比干巴巴的数字直观太多 🌈”

百科知识